Por: Mtro. Rodolfo Guerrero Martínez (México).

La irrupción de la Inteligencia Artificial (IA), especialmente los modelos de lenguaje grande (LLMs) y los agentes de IA (IA Agents), ha desencadenado una transformación sin precedentes en el entorno laboral y educativo, prometiendo un valor económico que podría ascender a miles de billones de dólares anuales a la economía global.

En ese orden de ideas, en la esfera legal y tecnológica, esta ola se percibe con optimismo respecto a la eficiencia, pero también con una creciente cautela sobre los riesgos cognitivos y regulatorios.

Dicho contexto dual de oportunidad y riesgo emerge una pregunta clave: ¿cómo se construyen y preservan el pensamiento crítico y el trabajo colaborativo cuando las máquinas están diseñadas para automatizar la labor cognitiva y la toma de decisiones? Si bien la IA ofrece ganancias significativas en productividad (hasta un 45% según algunos reportes de 2025) y una finalización de tareas hasta un 77% más rápida, existe un riesgo real y científicamente documentado de erosión de las facultades humanas esenciales como el pensamiento crítico, la memoria y la creatividad.

El verdadero peligro no radica en una IA que se rebele, sino en una IA que convenza a los humanos de ceder su capacidad intelectual, llevándonos a una Trampa de la Inteligencia Media (Middle-Intelligence Trap).

Por tanto, en el presente artículo, se explorará esta tensión, examinando la evidencia de la disminución cognitiva y delineando un nuevo conjunto de habilidades y marcos regulatorios necesarios para fomentar una colaboración humano-IA productiva y éticamente responsable.

La erosión del pensamiento crítico y el descargue cognitivo

Investigaciones recientes han establecido una correlación negativa significativa entre el uso frecuente de herramientas de IA y las habilidades de pensamiento crítico. El presente declive se explica principalmente por el fenómeno del descargue cognitivo (cognitive offloading), que es la delegación de tareas de pensamiento a las máquinas, lo que socava la capacidad de análisis independiente.

Los estudios que rastrean el impacto de los LLMs en el cerebro han arrojado resultados preocupantes:

(1) Reducción de la actividad neuronal. Una investigación del MIT Media Lab sobre estudiantes que usaban ChatGPT para escribir ensayos encontró que estos usuarios exhibían una menor retención de memoria, puntuaciones más bajas y una actividad cerebral disminuida al intentar completar tareas sin asistencia de IA.

(2) Pérdida de diversidad de Ideas. Se ha observado que los estudiantes que utilizan LLMs para tareas de investigación se enfocan en un conjunto de ideas más restringido, lo que resulta en análisis más superficiales y sesgados. Además, se reportó que el pensamiento divergente (la capacidad de generar múltiples soluciones a problemas) entre estudiantes universitarios disminuyó en un 42% en cinco años debido a la adopción generalizada de herramientas de IA.

(3) Pasividad mental. La conveniencia de obtener respuestas rápidas y aparentemente pulidas genera pasividad mental, disminuyendo la inclinación de los usuarios a evaluar críticamente la precisión o el matiz de las respuestas generadas por IA.

Este proceso de rendición gradual (similar a cómo las calculadoras disminuyeron el cálculo mental o los motores de búsqueda reestructuraron la memoria) amenaza con convertir las herramientas de aumento intelectual en sustitutos, lo que llevaría a un estancamiento intelectual.

Redefiniendo las habilidades duraderas para la colaboración humano-IA

Frente a la atrofia cognitiva impulsada por la inteligencia artificial, el foco debe cambiar de la pérdida de habilidades tradicionales a la adquisición de nuevas habilidades duraderas (durable skills) necesarias para interactuar eficazmente con la tecnología. De tal forma que, la IA no debe ser un reemplazo, sino un complemento del esfuerzo humano.

Por consiguiente, el desafío para las empresas y los profesionales del derecho, en este caso, es reconocer que la pericia real en IA no reside en dominar los prompts o instrucciones, sino en la capacidad humana de cuestionar, refinar y generar significado a partir de la salida del modelo de inteligencia artificial.

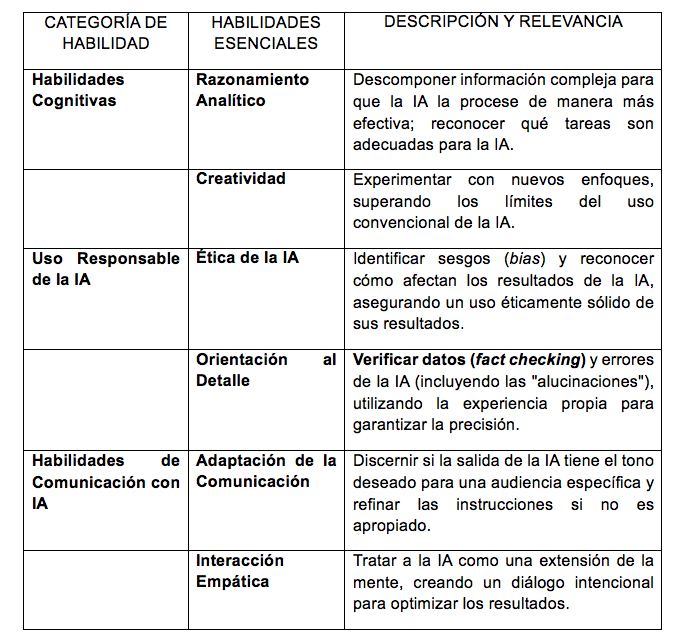

De hecho, una investigación reciente identificó 13 habilidades duraderas cruciales para impulsar la adopción exitosa de la IA en el lugar de trabajo, agrupadas en categorías esenciales, la cual se proyecta a continuación.

Elaboración propia a partir de Multiverse. (2025). Más allá del pensamiento crítico: 13 habilidades duraderas que impulsan la adopción de la IA. Recuperado de https://www.multiverse.io/en-GB/blog/beyond-critical-thinking-13-durable-skills-driving-ai-adoption

Estas habilidades son fundamentales para la colaboración en el ecosistema de Supertrabajadores (Superworkers) que emergen en 2025, definidos como empleados empoderados por la inteligencia artificial que optimizan su uso para aumentar significativamente su valor, productividad y producción.

Agentes IA, trabajo colaborativo y el marco regulatorio

El surgimiento de la IA Agente (Agentic AI) marca la nueva frontera del trabajo colaborativo. Debido a que estos agentes son sistemas autónomos capaces de tomar acciones y completar tareas complejas de principio a fin, como gestionar flujos de trabajo, programar reuniones o procesar pagos.

La integración de estos agentes está llevando a un nuevo modelo organizativo: sistemas operados por IA, pero dirigidos por humanos (AI-operated, human-led). Esta colaboración íntima, sin embargo, debe navegar un complejo panorama legal y ético, una preocupación crítica para los expertos en derecho y tecnología. En ese orden de las cosas, se expondrá en lo sucesivo los desafíos regulatorios, así como éticos en la colaboración.

Se debe entender que la velocidad de la innovación tecnológica supera la capacidad regulatoria global, creando un entorno fragmentado e inconsistente. Por ejemplo, en Estados Unidos, donde no existe una legislación federal integral, el enfoque se ha centrado en leyes estatales y la aplicación de marcos existentes (como la privacidad y la propiedad intelectual).

En consecuencia, los principales puntos de fricción tanto legal como éticos directamente ligados a la necesidad de pensamiento crítico y supervisión humana son:

(1) Sesgo y discriminación. La IA es tan buena como los datos con los que se alimenta; si los datos contienen sesgos preexistentes (por ejemplo, en la contratación o la calificación crediticia), la IA puede perpetuar la discriminación a escala. Jurisdicciones como Colorado, con su Colorado AI Act, ya exigen que los desarrolladores y desplegadores de sistemas de IA de alto riesgo utilicen un cuidado razonable para proteger a los consumidores contra la discriminación algorítmica.

(2) Transparencia y engaño. La necesidad de que los consumidores sepan cuándo están interactuando con sistemas de IA Generativa (GenAI) ha llevado a leyes de divulgación obligatoria. Por ejemplo, la Utah Artificial Intelligence Policy Act requiere la divulgación del uso de GenAI en comunicaciones con consumidores, especialmente en ocupaciones reguladas como la abogacía o la atención médica. California también ha promulgado la California AI Transparency Act.

(3) Fiabilidad judicial (alucinaciones). El pensamiento crítico es vital en la profesión legal, dado que los LLMs han demostrado ser fuentes poco fiables, propensas a generar citas de casos falsas (hallucinations) o tergiversaciones de la ley. Por esta razón, los tribunales estadounidenses han advertido y sancionado a abogados por presentar escritos basados en resultados de ChatGPT no verificados. Esto subraya que la orientación al detalle (una de las habilidades duraderas) y el juicio humano siguen siendo irremplazables.

Además, la colaboración exitosa con agentes de IA requiere, por lo tanto, que los líderes y profesionales inviertan no solo en las herramientas, sino en el marco de gobernanza y las habilidades humanas (blandas y cognitivas) para monitorear, auditar y aplicar principios éticos a los sistemas.

Conclusión general

La integración de LLMs y agentes de IA en las operaciones diarias es inevitable, significando que el futuro no es la abolición del pensamiento crítico y la colaboración, sino su reorientación. La solución pasa por fomentar un equilibrio, utilizando la inteligencia artificial para aumentar la eficiencia, mientras se refuerza deliberadamente el compromiso humano con el esfuerzo, la creatividad y la ética.

Cabe destacar que, las organizaciones que prosperarán serán aquellas que eviten la denominada Trampa de la Inteligencia Media, como ya se ha referido anteriormente, construyendo reservas cognitivas (hacer matemáticas mentalmente, escribir primeros borradores sin asistencia) y exigiendo fricción estratégica en sus sistemas, obligando a la participación y al pensamiento crítico humanos.

Asimismo, el desarrollo de habilidades duraderas como el razonamiento analítico, la ética de la IA y la adaptación de la comunicación es esencial para que la inteligencia artificial funcione como un copiloto útil, no como un sustituto del piloto humano.

En suma, lo establecido en lo precedente exhorta a entender que el derecho y la tecnología están intrínsecamente ligados en este cambio, donde la regulación se está adaptando lentamente para exigir transparencia y mitigar sesgos. Sin embargo, ninguna política puede obligar a un individuo a comprometerse profundamente con el aprendizaje si elige la ruta fácil. La elección, tal como subraya el análisis, sigue siendo nuestra: utilizar la IA para estancarnos o para alcanzar nuevas cimas de innovación y pensamiento.

Fuentes de consulta

Centuro Global. (2025). HR Best Practices for the Age of AI. https://www.centuroglobal.com/insights/hr-best-practices-for-the-age-of-ai

Chow, A. R. (2025). ChatGPT May Be Eroding Critical Thinking Skills, According to a New MIT Study. TIME. https://time.com/7295195/ai-chatgpt-google-learning-school/

Duke Learning Innovation & Lifetime Education. (2025). Does AI Harm Critical Thinking. Duke University.

ET Online. (2025). Forget jobs, AI is taking away much more: Creativity, memory and critical thinking are at risk. New studies sound alarm. The Economic Times.

Feng, Z. (2025). Is AI Luring Everyone Into a “Middle-Intelligence Trap?” University of Nebraska Omaha. https://www.unomaha.edu/news/2025/10/is-ai-luring-everyone-into-a-middle-intelligence-trap.php

Grose, J. (2025). A.I. Will Destroy Critical Thinking in K-12. The New York Times. https://www.nytimes.com/2025/05/14/opinion/trump-ai-elementary.html

Hasan, M. K. (2025). How AI quietly undermines the joy and effort of learning: a call for rebalancing education in the digital age. Medical Science, 87(8), 4693–4694. https://doi.org/10.1097/MS9.0000000000003456

Jackson, J. (2025). Increased AI use linked to eroding critical thinking skills. Phys.org.

Mayer, H., Yee, L., Chui, M., & Roberts, R. (2025). AI in the workplace: A report for 2025. McKinsey & Company.

***

Rodolfo Guerrero es abogado por la Benemérita Universidad de Guadalajara y maestro en derecho con orientación en materia Constitucional y administrativo por la misma casa de estudios. Es Socio Fundador y Representante Legal de la Sociedad Civil Coffee Law “Dr. Jorge Fernández Ruiz”. Socio fundador de la Academia Mexicana de Derecho “Juan Velásquez” A.C. Titular de la Comisión de Legaltech del Ilustre y Nacional Colegio de Abogados de México A.C. Capítulo Occidente. Vicepresidente de la Academia Mexicana

- Plumas NCC | La construcción de pensamiento crítico y trabajo colaborativo en tiempos de modelos de lenguaje y de agentes IA - octubre 13, 2025

- NCC Radio Cultura – Emisión 332 – 13/10/2025 al 19/10/2025 – Descubren entierros prehispánicos bajo una calle de Lima - octubre 13, 2025

- NCC Radio Tecnología – Emisión 332 – 13/10/2025 al 19/10/2025 – Presentan “Júpiter”, el superordenador más eficiente de Europa - octubre 13, 2025