México.

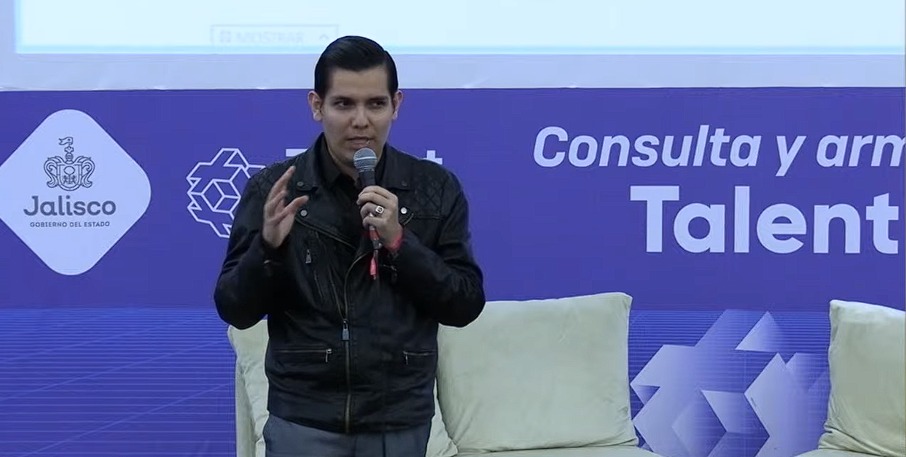

Nunca antes hubo tanta interacción con la tecnología como hoy y ha sido necesario pensar en una regulación. Por ello, Rodolfo Guerrero, CEO de Coffee Law S.C., habló sobre “Transversalidad digital: algoritmos y derechos humanos”, en Talent Land.

Ante la escasa coordinación de quienes lideran un proyecto o compañía de innovación, surgen las siguientes preguntas: ¿vulneran los derechos humanos en un desarrollo tecnológico?, de ser así, ¿cuáles son esos derechos?; ¿qué es el sesgo algorítmico?; ¿cómo garantizar la protección de los derechos digitales?

¿Qué es el algoritmo? “En la vida cotidiana realizamos una serie de pasos para hacer una tarea. Cuando involucramos una gran cantidad de datos en dispositivos inteligentes, debemos pensar cómo debe actuar ese algoritmo para que nos dé un servicio en particular”, definió Rodolfo.

«El algoritmo debería ser objetivo y neutro, pero eso se pierde con el tiempo y se pierde, no porque la naturaleza de la tecnología sea mala, si no por los prejuicios del programador que está detrás», resaltó el abogado.

“Problemas básicos como no acceder a la plataforma o si accedo, no poder acceder a todos los datos por el dispositivo al que estás conectado. Tal vez esos datos son para la población norteamericana y no para otros lugares”, dan una pauta de la discriminación que puede existir en el algoritmo y las plataformas.

La inteligencia artificial es uno de los precursores en la convergencia de toda esa naturaleza humana impregnada en los sistemas de cómputo, pues el algoritmo te discrimina a partir de la negligencia que hay durante el diseño y las creencias o metodologías que existen en los programadores.

Rodolfo recordó el caso en el que Amazon hacía que las oportunidades fueran mayoritariamente para los hombres que las mujeres. Se programó con un conjunto de programadores hombres y minimizaron las posibilidades para las mujeres. Se demostró esa negligencia, pues la muestra de datos con la que entrenaron esa inteligencia provenían casi todos de varones.

Google también cometió errores a partir de la programación. En la actualidad hay un fuerte debate sobre la inclusión, pero ¿cómo lo vas a hacer si ni siquiera el diseño lo ha incluido? “Personas con discapacidad, pueblos originarios, pero cómo les vas a dar acceso si ni siquiera los contempló en la programación”.

Rodolfo explicó que existen cuatro tipos comunes de sesgo relacionados con el aprendizaje automático: “sesgo de estereotipo, sesgo de muestreo, distorsión sistemática del valor y sesgo algorítmico”. A lo que añadió que debería existir un proceso de auditoría que evalúe en su totalidad un sistema de inteligencia artificial.

“Los algoritmos a veces se utilizan para fomentar la polarización de ideologías entre los usuarios, los algoritmos deberían ser agente de comunicación y no un promotor de la desinformación, ¿qué tanto deberían protegerse ante esta era algorítmica?”, cuestionó.

¿Cómo podrían obtenerse algoritmos más igualitarios?

“Para empezar, es preciso operar sobre los bancos de datos para que lleguen a representar cabalmente a toda la diversidad de la población. Algunas empresas ya lo hacen y trabajan tomando en cuenta las diferencias de sexo, nacionalidad o morfología”, dijo el CEO de Coffee Law S.C.

¿Podemos exigir que sea distinto? Rodolfo compartió que existen puntos a considerar en la implementación de los derechos digitales para la supresión de datos que manejan algoritmos de predicción y prescripción.

Entre ellos están: tener la posibilidad de no consentir el tratamiento de los datos, revocar nuestro consentimiento si ya lo hemos otorgado, solicitar la cancelación o supresión de los datos y solicitar la eliminación y olvido de nuestra presencia digital en cualquier plataforma que trate los datos de manera automatizada.

También, contó sobre Joy Buolamwini, quien fue la precursora en el tema de la justicia algorítmica. Realizó una investigación sobre las disparidades raciales por tipo de piel y de género que arrojaban los algoritmos de las tecnologías del reconocimiento facial disponibles en el mercado.

Reveló cómo Amazon, IBM, Microsoft y otros más, no pudieron clasificar rostros femeninos más oscuros con tanta precisión como los de los hombres blancos, lo que destruyó la “neutralidad” que se concebía de los algoritmos.

Entre la charla, Rodolfo recomendó la consulta de la Carta de Derechos Digitales que creó España “la cual ofrece un marco de referencia para garantizar los derechos de la ciudadanía en la nueva realidad digital y que nace con el objetivo de reconocer los retos que plantea la adaptación de los derechos actuales al entorno virtual y digital”.

Por: Leslie Almanza.

- NCC Radio Tecnología – Emisión 319 – 14/07/2025 al 20/07/2025 – Las aplicaciones y plataformas educativas también pueden ser atractivas para los jóvenes - julio 14, 2025

- NCC Radio – Emisión 319 – 14/07/2025 al 20/07/2025 – ¿Por qué la tecnología es adictiva para las nuevas generaciones? - julio 14, 2025

- NCC Radio Ciencia – Emisión 319 – 14/07/2025 al 20/07/2025 – En México desarrollan una bebida de agua miel para controlar la diabetes - julio 14, 2025